Internet: Digitale Technologien

Eine Tonne Bildmaterial

Gespräch mit Jan Gerber Pirate Cinema, Pad.ma, Ogg Theora-Spezialist

Eine Grundfrage ist, wie sich sich materielle Footage von digitaler unterscheidet? Ihr unterteilt bei dem Filmdatenbank-Projekt 0xdb Filme in Segmente, die den Zeilen enstprechen, die in Untertiteldateien gespeichert sind?

Jan Gerber: Konzeptuell geht es bei 0xdb nicht nur darum, einen algorithmischen Zugang zu Film zu probieren, sondern es ist auch eine Datenbank. Diese Datenbank hat vor allem einen archivarischen Aspekt. Es ist nicht so sehr eine Collage. 0xdb ließe sich als erster Schritt begreifen, der etwas anderes ermöglicht als nur eine Tonne mit Bild-Material zu haben, aus der man nach subjektivem Empfinden oder aufgrund von persönlichen Geschichten mit Filmen arbeitet. Es geht bei 0xdb darum, nicht nur die zufälligen Verbindungen aufzugreifen, wie es bei den Found-Footage (manchmal) der Fall ist. Insofern wird dann der algorithmische Zugang wichtig.

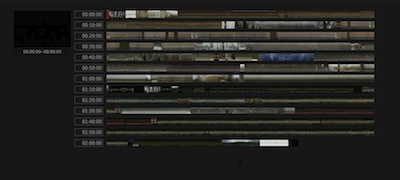

Die Sequenzen, die wir mit 0xdb aus den gespeicherten Filmen abbilden können, haben zwei Aspekte. Das eine ist der Timeline-View. Das ist eine Ansicht, die eine Kompression des Films auf der temporalen Ebene darstellt. Dadurch, dass wir eine Sekunde Film zu einem Pixel reduzieren (und es nur noch etwas vertikale Einzelbildinformation gibt), kann man sich einen Überblick über einen Film bzw. über viele Filme gleichzeitig verschaffen. In dieser Form hat das vorher nicht existiert bzw. war nicht möglich.

Die Filmclips sind auf einer ersten Ebene Ansichten von Suchergebnissen aus den durchsuchbaren Untertiteln. Was es in den Filmen gibt, kann man mittels der Untertitel suchen und dann anhand der Länge des Untertitels wieder als Film abspielen. Oft ist das ein ziemlich ungenauer Ausschnitt. Aber oft sind die Untertitel auch Sätze oder Teile von Sätzen, die als solche Sinn machen.

Dass das funktioniert, hat mit der semantischen Gestalt der Untertitel zu tun. Weil die Untertitel ja meist so geschrieben sind, dass das Lesen der Untertitel Sinn macht und dass man beim Lesen eines Untertitels die Vorkommnisse in den Filmen verstehen kann. Bei manchen Filmen ist das allerdings nicht möglich. Man bräuchte eigentlich drei mal so viel Text bzw. Zeit, damit Untertitel im Zusammenhang zum Bild alles richtig abbilden. Aber oft ist der Versuch, trotzdem gute Untertitel zu machen, ganz brauchbar. Und deswegen funktionieren dann die Clips, also die einzelnen Filmsegmente, ganz gut.

Ich glaube, dass das auch eher ein Anfang ist. Es wird noch ganz andere Formen geben, Filme zu unterteilen. Formen, die ästhetisch interessanter sind, genauer; Formen, die etwas anderes als die Durchsuchung anhand von Dialoguntertitelung ermöglichen. Mir schweben dabei Formen vor, die nicht nur als Rechercheinstrument funktionieren oder eine Referenz bilden, die ein »Nachschlagen« von Filmen ermöglichen. Sondern Formen, die die Grundlage bilden könnten für so etwas wie einen Found Footage-Film, aus denen also andere Filme oder Filme über andere Filme entstehen könnten. Die Suchmöglichkeiten, die wir mit 0xdb entwickelt haben, sind ein erster Schritt, um danach dann etwas neu zusammen zu setzen. Vielleicht muss das zunächst weiterhin »manuell« geschehen. Aber es gibt auch andere algorithmische Möglichkeiten. Beispielsweise müsste sich Szenen wieder erkennen lassen wie heute schon Gesichter. »Szenenerkennung«. Man könnte auch große Unterschiede in der Tonspur algorithmisch unterteilen.

Gibt es bereits Datenbanken, die so etwas machen?

Jan: Neulich habe ich etwas gesehen, wo mit Gesichtserkennung experimentiert wurde. Die Sache mit der Gesichtserkennung fand ja vor kurzem erst mit der »Smile-Detection« ihr Publikum. Die »Smile-Detection« bewirkt, dass bei traurigem Gesichtsausdruck die Kamera nicht auslöst. Der nächste Schritt ist die Gesichtserkennung. Das wird momentan aber eben vor allem bei Fotos gemacht. Längerfristig wäre die Idee, beispielsweise die Auftritte von Schauspielern in einem Film zu indizieren. Das sind aber auch nur Ansätze, wie man mit einer digitalen Datenbank von Bildern umgehen kann. Es geht natürlich dann auch immer darum, wie man diese Bilder einsetzt und wie man damit umgeht.

Die Herangehensweise an digitales Footage unterscheidet sich ja sehr von beispielsweise der Peter Tscherkasskys, ein österreichischer Found Footage Filmemacher, den wir in unserer Perspektive auf »filmvermittelnde Filme« als interessanten Protagonisten vorgestellt haben. Tscherkassky arbeitet analog mit analogen Filmen. Filme werden bei ihm vielfach übereinanderlegt, belichtet, gemischt und geschnitten, und es wird auch darauf herumgehackt. Die Filmgeschichte ist heutzutage auch als digitales Footage erreichbar, ebenso wie die digitalen Arbeitsmittel, mit denen man sie zusammenschneiden kann. Welche unterschiedlichen Herangehensweisen an vorgefundene Bilder siehst du zwischen der analogen und der digitalen Bildverarbeitung?

Jan: Was bisher noch nicht entstanden ist, ist eine genuine technische Form, mit den digitalen Mitteln und den häufig digitalen Formen, die die Dinge im Internet haben, umzugehen. Ich möchte das mit der Videotechnik vergleichen. In den 1970er Jahren wurde ja viel mit Videotechnik und Videomischern experimentiert. Es wurde versucht, mit Video Sachen anders zu machen als mit Film. Damals ist mit Video eine andere Qualität, etwas Neues und Eigenes entstanden. Vor allem das Videomischen hat eine neuartige Arbeit am Material und einen neuen kritischen Umgang mit ihm ermöglicht. Die digitalen Videotechnologien haben noch nicht eine eigene, neue Form hervorgebracht, die sich so grundlegend von der Videotechnologie unterscheidet, wie diese vom alten Kino. Die algorithmische Arbeit, das Computerprogramm, ist bisher noch nicht als neuartiges Herstellen von Filmen verstanden worden. Das Ergebnis von digitalen Bearbeitungsprogrammen wird noch nicht als neuer »Film« verstanden.

Es gibt im Word Wide Web ja zahlreiche Fankulturen, aus denen heraus solche neuen »Filme« entstehen. Mir fällt zum Beispiel das Nachstellen von Filmen ein oder das parodistische Umschneiden von Trailern, so genannte »Spoofs«.

Jan: Ich schaue mir viele Filme am Computer an, ganz oder auch nur teilweise. Sicher kann man sich dann auch über einen Film unterhalten. Das ist die eine Sache. Aber ich hatte schon oft den Wunsch, daraus sofort den besseren Film zu schneiden. Der Impuls beim Schauen von Filmen ist bei mir oft: »Der Film ist wirklich gut, aber nur, wenn man diesen Teil hier rausnimmt, diese Sache hier wegnimmt und aus diesem anderen Film noch das hereinnimmt.« Ich hatte immer wieder Lust, zu formulieren, das es bessere Fassung eines Films geben könnte. Vorstellbar ist das ja schon jetzt. Aber tatsächlich passiert es dann doch nicht – wahrscheinlich wegen der Frage des Copyrights.

Vielleicht passiert so etwas schon, aber es wird nicht online gestellt.

Jan: Es gibt immer wieder künstlerische Arbeiten, die sowas wie Zusammenschnitte sind. Zusammenschnitte, die aus einer Datenbank kommen oder algorithmisch gefunden wurden, auch wenn sie dann letztendlich an einem Schnittplatz hergestellt sind. Mir fällt gerade eine Arbeit ein aus Ägypten, von der ich gehört habe, in der aus ägyptischen Filmen die Szenen zusammengetragen wurden, in welchen die Pyramiden zu sehen sind. Ingesamt dauert das etwa zwei Stunden. Im letzten »Pirate cinema« hatten wir die Abspänne von allen Filmen zusammengeschnitten, die wir gezeigt hatten.

So etwas gibt es in größerem Maße dann aber nicht, solche Videos in den großen Videoportalen kann man an einer Hand abzählen, und selbst dann stammen sie fast alle aus dem Kunstkontext. Im Musikkontext gibt es so etwas: Leute stellen in Weblogs Playlists zusammen mit Stücken, die sie gerne mögen. Gut, der Vergleich hinkt, die Stücke sind ja nicht auseinander geschnitten. In Filmzusammenhängen sind es beispielsweise Blog-Posts, die auf Clips verweisen, in denen Ausschnitte aus dem Film zu sehen sind. Neulich beispielsweise wurde die längste ungeschnittene Martial-Art-Szene gesucht. Gefunden wurde ein phillipinischer Film von 2005. In dem Film gibt es eine 15-minütige Kampfszene, in der die Kamera die ganze Zeit mit dabei ist. Aber Filme funktionieren anders als Musik. Sie brauchen mehr (längere) Aufmerksamkeit, wenn sie konsumiert werden. Aber für mich wäre es schon sehr wichtig, dass ich, wenn ich einen Text über eine Szene habe, mir die Szene dann auch gleich daneben anschauen kann.

Und dann auch ähnliche Szenen. Das muss ja nicht gleich wieder in Form eines Films geschnitten sein, aneinandergehängt und vertont.

Jan: An der Universität von Süd-Kalifornien(USC) gibt es gerade ein Projekt, das eine Plattform aufbaut, welche eine Infrastruktur zum Zitieren von Filmen aufbauen will, »Critical Commons«. Bisher ist die Website noch nicht öffentlich, aber es gibt ein Wiki, in dem man sich anschauen kann, was die dort vorhaben. Da geht es weniger um die ganzen Filme, sondern darum, was unter dem Aspekt des »Fair use« im wissenschaftlichen Kontext möglich ist. Wie weit das möglich ist, mit Bewegtbildern zu arbeiten und wie man diese Bilder dann einbinden kann. Es geht darum, das juristisch, technisch und sozial gerade in der Praxis auszuloten bzw. zu sehen, was für Formen notwendig sind, damit es im wissenschaftlichen Alltag ernsthaft eingesetzt werden kann.

Entwickeln die dort eine neue Technologie oder machen die das, um zu sehen, was sich juristisch für Probleme ergeben oder ob es überhaupt Widerstände gibt?

Jan: Konkret geht es bei »Critcal Comments« weniger um Technologie. Es ist eine Videoplattform, ähnlich wie Youtube. Wenn bspw. an einer Universität in einem Kurs bestimmtes Filmmaterial angeschaut werden soll oder referenziert wird, sollen die Lehrenden das Filmmaterial zusammen mit Texten auf dieser Website ablegen können. Daraus sollen wieder weitere Einheiten zusammen gebracht werden können. Sowas kann natürlich auch leicht schiefgehen und am Ende kommen nur Videomitschnitte von Veranstaltungen dabei heraus – vorne steht jemand und erzählt etwas. Offensichtlich wird bei »Critical Commons« aber nicht der ganze Film als Grundlage genommen (und also vorrätig gehalten), um dann Ausschnitte referenzieren zu können. Stattdessen kann man nur den unmittelbaren Kontext einer Szene sehen.

Das »Film Konsortium«-Projekt, das wir in Indien planen, scheint mir in diesem Zusammenhang interessanter. Das ist ein Zusammenschluss von mehreren indischen Filmhochschulen, die gemeinsam eine Filmdatenbank aufbauen wollen, die hauptsächlich zur internen Benutzung geplant ist. Es geht darum, Film auf eine Art zu verwenden, die es erlaubt, ähnlich wie bei »Pad.ma«, mehrere Annotationsebenen übereinander zu legen, bestimmte Bereiche zu markieren, und diese Bereiche dann wiederum in anderen Texten zu referenzieren. Die Arbeit beruht weiterhin sehr auf Text.

Sie haben grundsätzlich ein Interesse daran, ihre Praxis der Filmanalyse und -referenzierung mit so einer Online-Datenbank zu erweitern, um herauszufinden, inwiefern das für das, was sie gerade machen, wichtig ist. Ashish Rajadhyaksha hat gerade ein Buch veröffentlicht zur Geschichte des indischen Films. Das Buch ist so gestaltet, dass er zu jeder Szenenbeschreibung drei Stills hat. Drei deshalb, damit man wenigstens etwas Bewegung oder Dynamik sehen kann. Dieses Buch könnte natürlich sehr gut mit so einer Datenbank umgesetzt werden; bzw. als Extra gäbe es eine Online-Version.

Mich interessiert grundsätzlich, was passiert, wenn die Praxis und Technik des Filmschnitts mit der des Wiki zusammenkommt, welche neue Formen daraus entstehen können. Im Moment arbeite ich im Zusammenhang der Wikipedia mit anderen daran, für die Wikipedia auch die Möglichkeit kollaborativ erarbeiteter Videoinhalte zu haben. Man muss sich das so vorstellen, dass wie in der Wikipedia selbst bestimmte Teile eines Texte von einer beliebigen Person geändert, hinzugefügt oder gelöscht werden können, auch Videofilme so online bearbeitet werden. Es gibt dort verschiedene Ideen oder Ansätze, was online-/kollaboratives Filmschneiden oder Media-Editing sein könnten. Das befindet sich aber noch auf der konzeptuellen Ebene. Interessante Möglichkeiten könnten daraus entstehen.

Interessant ist, was momentan bei den technischen Grundlagen geschieht in dem Bereich von Editieren, Remixen und Kompilieren verschiedener Szene aus verschiedenen Filmen. HTML, das Format, in dem Webseiten geschrieben werden, wird gerade so verändert, dass in Zukunft Videos genauso einfach benutzt werden können wie schon immer Bilder. Allerdings auch bis dahin, dass die zeitlichen Aspekte von Film zugänglich sein, man kann ganz einfach Ausschnitte oder sogar Recuts angeben, und der Webbrowser zusammen mit dem Webserver kümmern sich um alles.

Für den Video-Codec »Ogg Theora« gibt es dafür auch bereits eine sich sehr ausbreitende Unterstützung auf den Webservern. Ich kann damit dann sagen: »Ich möchte von diesem Video Minute 3:07 bis 3:35 und dann von jenem anderen Video 2 Sekunden.« Das funktioniert dann auch zusammen mit Archiven wie www.archive.org. Mit dieser Technologie wird es relativ trivial, so etwas wie eine Playlist oder Cutting List zusammenstellen, weil es nur noch darum geht, eine Datei mit diesen Referenzen auf einen Webserver zu lagern. Und dann können sich das alle anschauen.

Das ist auch umgekehrt interessant, weil man so selbst keine Kopie vorrätig halten muss.

Jan: Die »Webfragments«-Gruppe arbeitet daran, dass das unabhängig vom Videoformat funktioniert. Der Server muss das allerdings immer unterstützen. Mit der Spezifkation könnte das dann für verschiedene Formate implementiert werden. Es sieht so aus, als würde das in absehbarer Zeit funktionieren.

Das Format Ogg Theora wird jetzt schon von Firefox unterstützt. Firefox wird auch nur freie Formate unterstützen, weil sie sonst die Software nicht distribuieren dürften. Und auch sonst nicht sicherstellen können, das für alle Betriebssysteme die gleiche Funktionalität da wäre. Es gibt keinen gemeinsamen Videocodec, der auf allen Betriebssystemen standardmäßig vorhanden ist.

Bisher muss man ja eine recht komplizierte Struktur programmieren, damit das Video auf verschiedenen Betriebssystemen abgespielt werden kann.

Jan: Ja, bisher war das kompliziert. Inzwischen ist man aber der Auffassung, dass Video ein elementarer Bestandteil des World-Wide-Web geworden ist. Daher sollten Videos genauso behandelt werden wie andere Elemente (Bilder, Texte, Grafiken) und nicht erst durch Plugins ermöglicht werden.

Aber gleichzeitig ist so, das es nur auf dem Papier so sein wird, weil es in der Realität eben kein Videocodec, keine Möglichkeit, Videos abzuspielen gibt, die auf allen Betriebssystemen gleich wäre. Man muss immer eine bestimmte Playersoftware installiert haben.

Jan: Das ist das Besondere an der aktuellen Version von Firefox, der Version 3.5: Für alle Betriebssysteme soll die gleiche Videofunktionalität automatisch verfügbar sein. Danach wird sich zeigen, wie andere Browser-Hersteller damit umgehen. Die Frage ist, ob genügend Leute diese Ogg Theora-Videos benutzen werden, so dass die Hersteller dieses Format dann übernehmen. Ähnlich war es ja damals mit den PNG-Bildern (die eine freie Alternative zum mit Patenten und Lizenz-Gebühren belegten GIF-Format sind), Erst wurde das Format nur von einem Browser unterstüzt. Es hat eine Weile gedauert, bis die anderen nachgezogen sind.

Insgesamt ist die Videocodec-Landschaft durch Softwarepatente sehr stark fragmentiert. Daher ist es im Moment nur möglich, proprietäre Software mit diesen lizensierten Codecs anzubieten Firefox könnte eben nicht mit Funktionalität für das h.264-Format ausgestattet sein.

Gibt es große Videoportale, die bereits Ogg Theora verwenden?

| [1] | Siehe das Theora Cookbook |

Jan: blib-TV hatte eine Zeitlang Unterstützung für Ogg Theora [1], wenn man eine Ogg Theora-Videodatei hochgeladen hat. Allerdings machten sie auch einen Flash-Player daraus. Daily Motion hat eine Demo-Version, in der der neue HTML5-Videotag benutzt wird.

Und dann gibt es eben Videohosting-Möglichkeiten, die nicht so sehr Portale sind. Wie archive.org, die alle Videos, die hochgeladen werden, in eine Ogg Theora-Version umwandlen, die für Streaming brauchbar ist. Dann gibt es wikipedia-commons, auf das auch Videos hochgeladen werden können. Zur Zeit wird das ausgebaut.

In diesem Zusammenhang ist das andere wichtige Datum 2010. Dann sollen die Lizenzgebühren für h.264 bekanntgegeben werden. Also: Wieviel kostet es, h.264-Videos auf einer Website anzubieten? Bisher muss man für Encoder- und Decoder-Software bezahlen. Und zusätzlich gibt es die Option, das ab 2010 Lizenzen eingeführt werden für das Abspielen von Videos auf Webseiten. Pro angeschautem Video müsste dann der Betreiber der Website eine bestimmte Lizenzgebühr zahlen. Das ist ja z.B. auch bei MP3-Dateien auch so. Damit wurde die Netzradio-Szene klein gehalten. 2005 wurde eine Änderung eingeführt, dass man erst ab 200.000 Streams pro Jahr zahlen muss.Wie die diesbezügliche Regelung für h.264 sein wird, ist noch völlig unklar, aber es ist davon auszugehen, das Lizenzgebühren erhoben werden. Marktmachttechnisch ist es für die großen Player natürlich interessant, ihre Konkurrenz klein zu halten. Damit können sie sicherstellen, das es nicht noch weitere Videoportale geben wird.

Das könnte aber wiederum auch dazu führen, das es doch innovative und interessante Konzepte mit Video im Internet gibt, die dann gerade eben nicht h.264 einsetzen, weil sie das nicht über Jahre finanzieren können und deshalb auf Ogg Theora setzen.

Man kann anhand dieser Lizenzierungen sehr gut erkennen, dass der Zusammenhang von Video und Internet viel mit dem Druck von globalen Konzernen zu tun hat. Deshalb finden viele der interessanten Sachen in halb-öffentlichen oder gar halb-legalen Räumen statt.

Wie siehst du in diesem Zusammenang Youtube?

Jan: Beim Versuch, sich mit den Rechteinhabern zu einigen, hat Youtube ein Content-Identifizierungs-System entwickelt, das versucht, bei hochgeladenen Videos den Rechteinhaber herauszufinden. Das funktioniert allerdings nicht besonders gut. Beispeilsweise werden Videos abgeschaltet, die eigentlich unter »Fair Use« gezeigt werden könnten. Ein Fernsehsender benutzt Bilder, die frei verfügbar sind und durch den Umweg über das Copyright an der Fernsehsendung wird dann plötzlich derjenige, der etwas produziert und dann frei verfügbar gemacht hat, aufgefordert, das herunterzunehmen, weil die Bilder als dem Fernsehsender gehörend erkannt werden. Auf jeden Fall hat Youtube den Rechteinhabern die Möglichkeit gegeben, sich anzumelden und zu sagen, was ihre Werke sind. Sie können ihre Werke dort hinsenden und es gibt einen automatischen Identifizierungsprozess. Dann können sie entscheiden, was mit dem Material, das User hochgeladen haben, passieren soll. Eine Möglichkeit ist, dort Werbung anzeigen zu lassen und die Hälfte der Werbeeinnahmen zu bekommen, oder sie können sagen, das etwas heruntergenommen werden soll, oder sie können sagen, es ist mir egal.

An dieser Stelle kommt man vom Praktischen auch schnell wieder in die theoretischen Fragestellungen hinein: Was ist eine Kopie einer unerlaubten Sendung? Was sind erlaubte Formen von Zitat? Was sind didaktische, beispielgebende, auf etwas deutende Zitate? Eigentlich müsste viel mehr von dem, was im Internet mit Film gemacht wird, unter »Fair Use« fallen.

Jan: Meine Auffassung ist, dass das nicht-kommerzielle Zirkulieren von Inhalten nicht Distribution im klassischen Sinne ist. Es ist Austausch. Es kann nicht sein, dass jede Form von Kopie illegal ist. Dann wäre kulturelle Produktion nicht mehr möglich – also Analyse, Kritik, Reflektion, Diskussion.

Das Gespräch führte Erik Stein